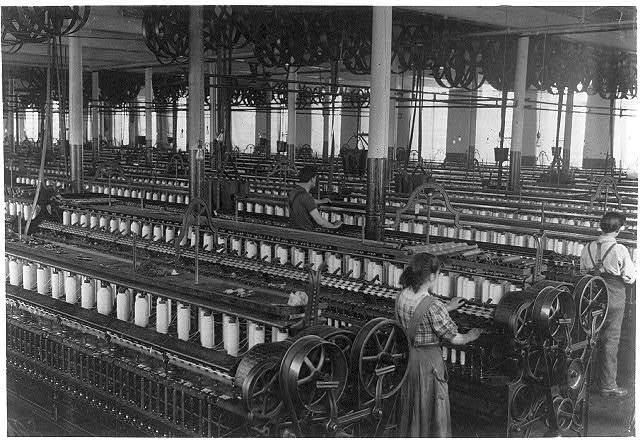

Kombiniere RPA, GPT und DeepL mit deinen menschlichen Copywritern

Bau Dir Deine Textfabrik!

Du bist in guter Gesellschaft

Stand Out

Von Produktdaten zum personalisierten Kundenerlebnis

-

Volle Kontrolle →

Höhere Produktivität, Zuverlässigkeit und Zeitersparnis

Mit der Data-to-Text-Automatisierungslösung von AX Semantics kannst du hochwertige Texte auf der Grundlage strukturierter Daten erstellen, aktualisieren und lokalisieren. Verwandel deine Daten in effektive Texte und mach sie mit automatisierten Workflows zum Selbstläufer!

.jpg?width=960&height=482&name=Data%20to%20Text%20Product%20Page%20Website%20(960%20x%20482%20px).jpg)

-

Go Epic →

Nutze das volle Potenzial deines Online-Shops

Steigere deinen Umsatz mit Produktbeschreibungen, die wie ein überzeugendes Verkaufsgespräch wirken und den Kunden den Einblick geben, den sie brauchen, um informierte und zufriedenstellende Kaufentscheidungen zu treffen.

.png?width=960&height=540&name=Epic%20Product%20Descriptions%20%E2%80%93%20Spotlight%20(1).png)

-

Automatisierte Aktualisierung →

Stets up-to-date und relevant auf Knopfdruck

Sorge mühelos dafür, dass deine Inhalte zuverlässig und aktuell bleiben, mit konsequent aktualisierten Produktbeschreibungen.

-

110 Sprachen →

International in bis zu 110 Sprachen

Bring deine Content-Strategie auf ein neues Level: Die integrierte Systemlandschaft für Data2Text Automatisierung ermöglicht es dir, mehrsprachige Produkttexte auf Knopfdruck zu erstellen und aktuell zu halten – einzigartig, fehlerfrei und skalierbar.

%20(1).png?width=960&height=640&name=Beipspiel%20Texte%20Darstellung%20Cases%20(960%20x%20640%20px)%20(1).png)

-

Einzigartiges Nutzererlebnis →

Verwandel generische Produktseiten in personalisierte Pitches

Präsentiere Besuchern deines Online-Shops personalisierte Produktbeschreibungen, die speziell auf ihre individuellen Bedürfnisse und Phase der Customer Journey zugeschnitten sind.

.png?width=1920&height=1080&name=Grafik%20Personalized%20Commerce%20(1).png)

-

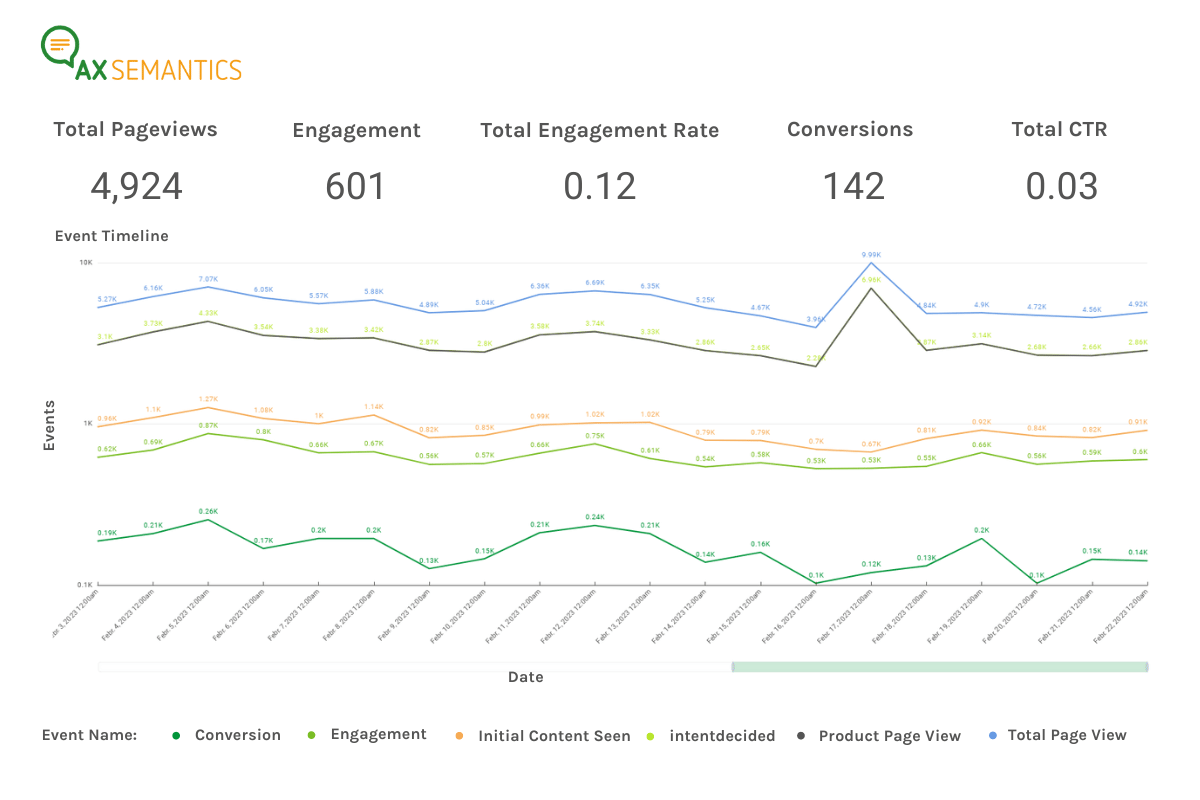

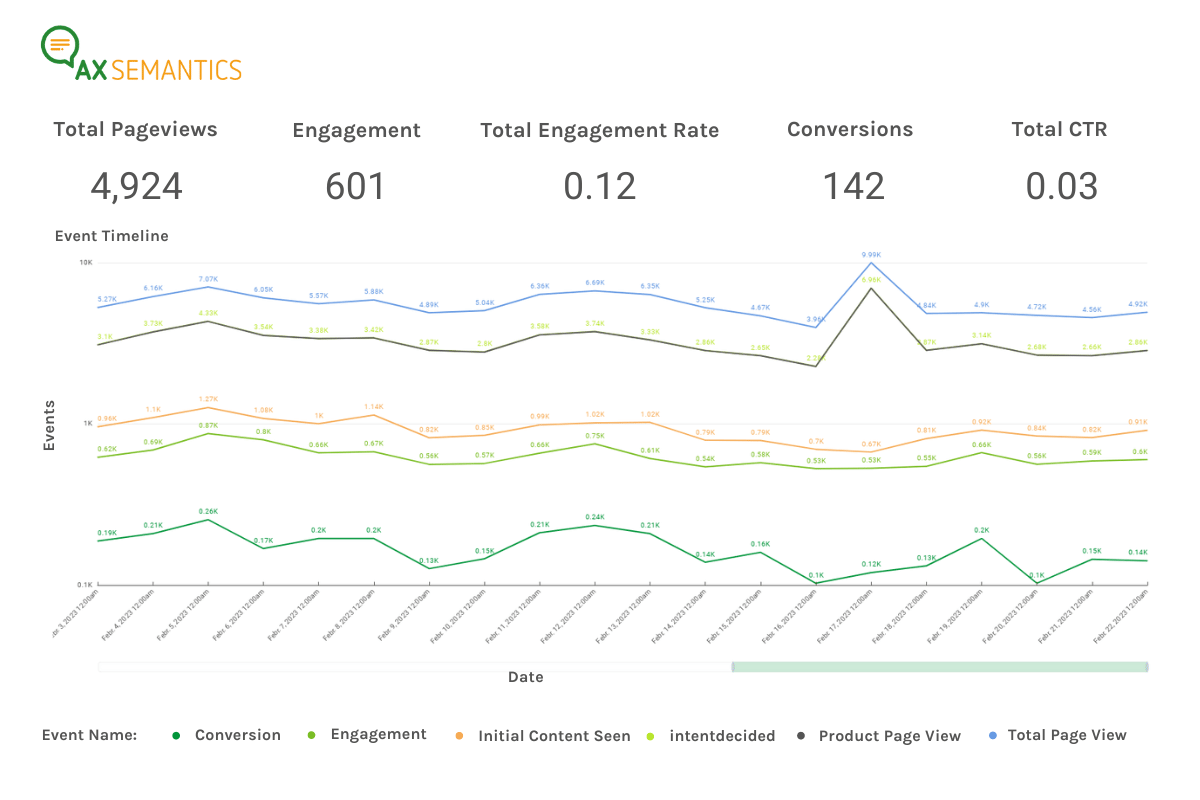

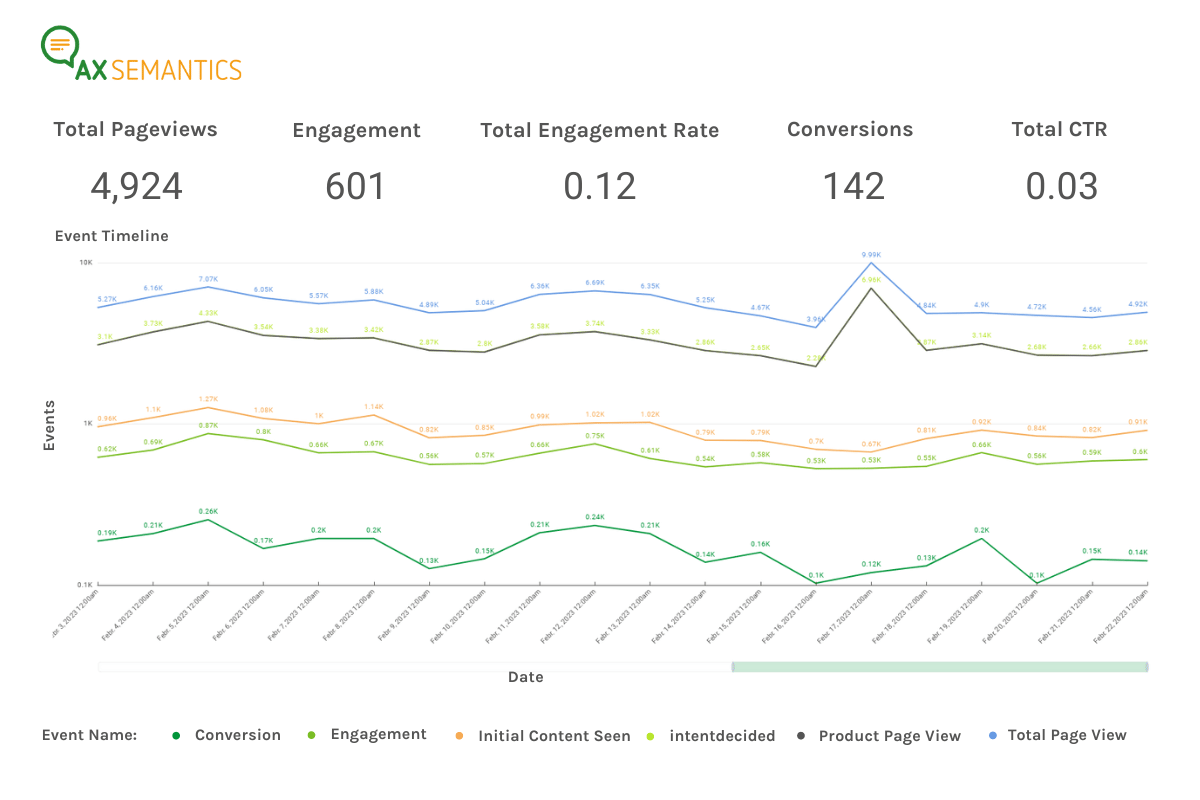

Datengestützte Optimierung →

Profitiere von unserem Metrics Add-on, um Echtzeit-Daten zu sammeln und deinen Content zu analysieren

Informierte, datengestützte Entscheidungen zu treffen, ist in der heutigen E-Commerce-Landschaft von zentraler Bedeutung. Metrics gibt dir Einblicke aus erster Hand. So kannst du deine Produktseiten auf der Grundlage echter Daten und nicht nur deiner Intuition verfeinern und anpassen.

.jpg?width=960&height=482&name=Data%20to%20Text%20Product%20Page%20Website%20(960%20x%20482%20px).jpg)

.png?width=960&height=540&name=Epic%20Product%20Descriptions%20%E2%80%93%20Spotlight%20(1).png)

%20(1).png?width=960&height=640&name=Beipspiel%20Texte%20Darstellung%20Cases%20(960%20x%20640%20px)%20(1).png)

.png?width=1920&height=1080&name=Grafik%20Personalized%20Commerce%20(1).png)

Stand Out

Von Produktdaten zum personalisierten Kundenerlebnis

- Volle Kontrolle

- Go Epic

- Automatisierte Aktualisierung

- 110 Sprachen

- Einzigartiges Nutzererlebnis

- Datengestützte Optimierung

Höhere Produktivität, Zuverlässigkeit und Zeitersparnis

Mit der Data-to-Text-Automatisierungslösung von AX Semantics kannst du hochwertige Texte auf der Grundlage strukturierter Daten erstellen, aktualisieren und lokalisieren. Verwandel deine Daten in effektive Texte und mach sie mit automatisierten Workflows zum Selbstläufer!

.jpg?width=960&height=482&name=Data%20to%20Text%20Product%20Page%20Website%20(960%20x%20482%20px).jpg)

Nutze das volle Potenzial deines Online-Shops

Steigere deinen Umsatz mit Produktbeschreibungen, die wie ein überzeugendes Verkaufsgespräch wirken und den Kunden den Einblick geben, den sie brauchen, um informierte und zufriedenstellende Kaufentscheidungen zu treffen.

.png?width=960&height=540&name=Epic%20Product%20Descriptions%20%E2%80%93%20Spotlight%20(1).png)

Stets up-to-date und relevant auf Knopfdruck

Sorge mühelos dafür, dass deine Inhalte zuverlässig und aktuell bleiben, mit konsequent aktualisierten Produktbeschreibungen.

International in bis zu 110 Sprachen

Bring deine Content-Strategie auf ein neues Level: Die integrierte Systemlandschaft für Data2Text Automatisierung ermöglicht es dir, mehrsprachige Produkttexte auf Knopfdruck zu erstellen und aktuell zu halten – einzigartig, fehlerfrei und skalierbar.

%20(1).png?width=960&height=640&name=Beipspiel%20Texte%20Darstellung%20Cases%20(960%20x%20640%20px)%20(1).png)

Verwandel generische Produktseiten in personalisierte Pitches

Präsentiere Besuchern deines Online-Shops personalisierte Produktbeschreibungen, die speziell auf ihre individuellen Bedürfnisse und Phase der Customer Journey zugeschnitten sind.

.png?width=1920&height=1080&name=Grafik%20Personalized%20Commerce%20(1).png)

Profitiere von unserem Metrics Add-on, um Echtzeit-Daten zu sammeln und deinen Content zu analysieren

Informierte, datengestützte Entscheidungen zu treffen, ist in der heutigen E-Commerce-Landschaft von zentraler Bedeutung. Metrics gibt dir Einblicke aus erster Hand. So kannst du deine Produktseiten auf der Grundlage echter Daten und nicht nur deiner Intuition verfeinern und anpassen.

.png?width=1200&length=1200&name=Misumi%20(2).png)

.png?width=1200&length=1200&name=metav%20(2).png)

.png?width=1200&length=1200&name=Otto%20(1).png)

.png?width=1200&length=1200&name=TVH%20(2).png)

.png?width=1200&length=1200&name=Mytheresa%20(1).png)

.png?width=1200&length=1200&name=News.de%20(1).png)

.png?width=1200&length=1200&name=billiger.de%20(1).png)

.png?width=1200&length=1200&name=Kofferworld%20(1).png)

Das Textautomatisierungstool für verlässliche Produktbeschreibungen

AX Semantics versetzt dich in die Lage:

- Für jedes Produkt eine wirksame Produktbeschreibung zu haben – auch für die kleinste Schraube

- Deine Produkte in anderen Ländern in der jeweiligen Sprache anzubieten

- Schneller Produkte online anbieten zu können als deine Konkurrenz

- Dich auf jede Produktbeschreibung ungesehen verlassen zu können

- Eine wirkliche Erleichterung für dein Content Team zu schaffen

Sei genauso erfolgreich wie unsere Kunden

Das sagen einige unserer begeisterten Fans

Dank AX Semantics wird die Erstellung von Produktbeschreibungen für eine Produktgruppe mit 5.000 und mehr Artikeln zum Kinderspiel.

Niels Willaert

Spezialist für Produktmarketing bei TVH

Mit AX Semantics können wir das, was wir intern mit viel Excel und viel Zuarbeit gestemmt haben, in einem automatischen Prozess abbilden, der natürlich ganz anders skaliert.

Andreas Serra

Team Leader Engineering Data Service bei Misumi

Großartiger Support und ein intelligentes Produkt, das zu Ergebnissen führt - es verbessert Ihr Endergebnis!

Chris Hanage

MD at Nextville

Wir erreichen 57% mehr Conversions dank automatisierter Produktbeschreibungen.

Stephan Bayer

Geschäftsführer der Metav Werkzeuge GmbH

Ohne automatisierte Texterstellung wäre es unmöglich, Beschreibungen für das riesige Produktsortiment von billiger.de zu verfassen.

Bernd Vermaaten

CEO von billiger.de

Unsere automatisierten Produktbeschreibungen sind von manuell geschriebenen nicht zu unterscheiden.

Vanessa Wurster

Leiterin E-Commerce & Online-Marketing und Lisa Bleser, Teamleiterin Online-Marketing

Dank der automatisierten Texterstellung können wir Tausende einzigartige Produktbeschreibungen in 17 Sprachen verfassen.

Jakob Høy Biegel

CEO von Skatepro

Dank der AX Semantics Software zur Textautomatisierung haben wir in nur 2 Monaten mehr als 33.000 einzigartige Produktbeschreibungen erstellt.

Mirela Comor

Product Content Manager bei Lyreco Germany

AX Semantics: Die Plattform, die Kunden lieben

Entdecke mehr

Wissenswertes zum Thema Automatisierung

25. Mär 2024 | Auto-Updating Text

Google ändert Rich-Suchergebnisse für Anleitungen und FAQs

Verstoßen automatisierte Texte gegen die aktuellen Google-Richtlinien? Diese Frage und mehr werden i...

Weiter lesen

14. Mär 2024 | E-Commerce

Neue Strategien zur Aktualisierung von Produktbeschreibungen

Wie sieht eine gelungene Aktualisierungsstrategie aus? Fakt ist sie ist notwendig, denn Produkttexte...

Weiter lesen

7. Mär 2024 | Automatisierte Texte + Produktbeschreibungen

Wie Automatisierung Qualität erhöht, und Google zufriedenstellt: das Google Core Update März 2024

Google Core Update März 2024 betont die Bedeutung qualitativ hochwertiger Inhalte. Automatisierungsl...

Weiter lesen

22. Jan 2024 | E-Commerce

5 Dinge, die du wissen solltest, um mit realistischen Erwartungen an die Arbeit mit (Chat)GPT & Co. zu gehen

LLMs wie (Chat)GPT & Co. unterstützen jede Phase des Copywritings - aber man muss wissen, was si...

Weiter lesen

_Leader_Leader_200x260.png?width=1200&length=1200&name=NaturalLanguageGeneration(NLG)_Leader_Leader_200x260.png)